一. 纽科姆悖论(Newcomb's paradox)

这个思想实验在《哲学家们在吵什么?》中提到过(问题19),也称为“纽科姆问题”,因为严格来说不算一个“悖论”。

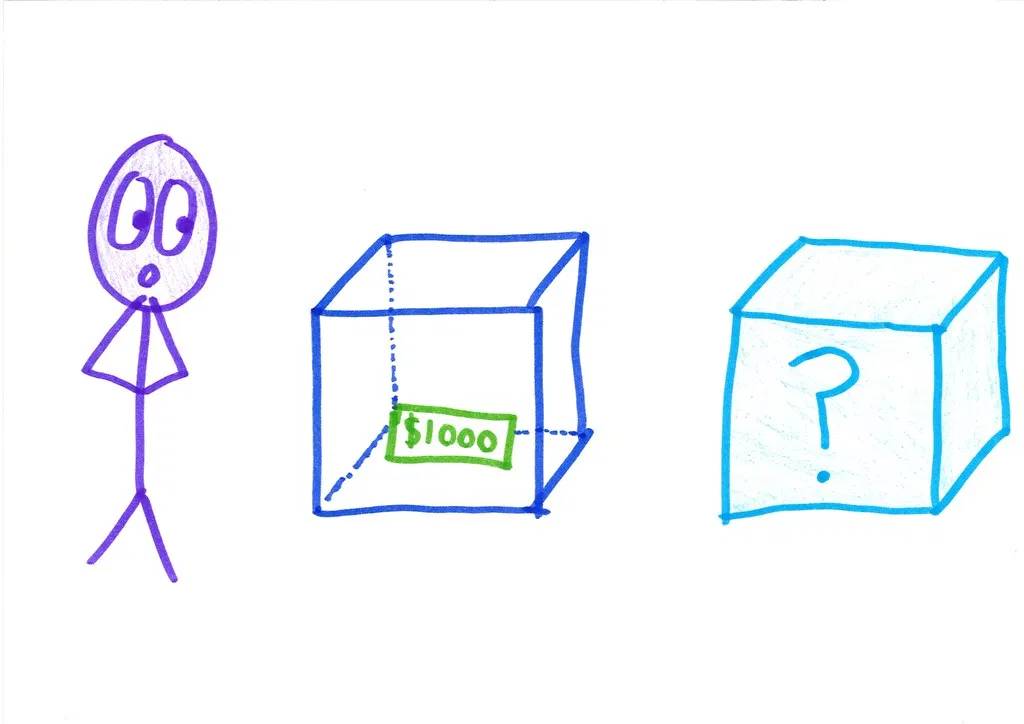

假如有两个箱子:A和B。A箱是透明的,你可以看到里面有1000元;B箱是关闭且不透明的。

B箱有且只有两种可能:空的,或者有一百万元。

现在你有两个选择:(1)只打开B箱;(2)同时打开两个箱子。你可以拿走你打开的箱子里的钱(如果有的话)。

假设有一个超级AI,它可以预测人类的行为,并且根据过去的记录,百发百中。这个超级AI已经对你的行为做出了预判,并且做出了相应的反应:

-

如果它认为你只会打开B箱,则会在B箱中放入一百万元。

-

如果它认为你会打开两个箱子,则不会在B箱中放入任何东西。

你的选择是什么?

二. 玛丽的房间

玛丽是一位出色的神经科学家,但是她从小到大,都生活在只有黑白两色的房间里,通过黑白显示屏调查世界。

玛丽知道人类已知的所有有关视觉、颜色的所有物理、生物学等知识和信息。例如,她知道不同颜色的波长组合是怎样刺激视网膜,视觉信号是怎样通过中枢神经系统使人辨认出不同颜色的。然而,玛丽从来没有亲身体验过色彩。

有一天玛丽的黑白屏幕出了问题,屏幕上出现了一个红色的苹果。这时候,玛丽能从中学到新的东西吗?

三. 莫利纽兹问题

youtu.be/1TdFAHtqPbs问题:有一个人天生眼盲,但可以透过触觉来分辨物体形状,如她可以摸到球形的感觉、立方体的感觉,等等。假设有一天这个人突然恢复了正常视力,眼前放了一个球体和立方体,她能不能够单纯以视觉来分辨出哪个是球体,哪个是立方体?

根据医学经验(对于先天性白内障的治疗),病人在复明后并不能单纯以视觉分辨不同的形状,必须通过体验和学习才行。但是也有人argue目前的医疗条件无法在手术后100%恢复视觉,因此无法达到思想实验中的条件。

四. 中文房间问题

维基链接。感谢libgen提出。

youtu.be/TryOC83PH1g一个对中文一窍不通,只说英语的人关在一间只有一个开口的封闭房间中。房间里有一本用英文写成的手册,指示该如何处理收到的汉语讯息及如何以汉语相应地回复。房外的人不断向房间内递进用中文写成的问题。房内的人便按照手册的说明,寻找合适的指示,将相应的中文字符组合成对问题的解答,并将答案递出房间。

约翰·希尔勒认为,尽管房里的人可以以假乱真,让房外的人以为他说中文,但事实上他压根儿不懂中文。在上述过程中,房外人的角色相当于程序员,房中人相当于计算机,而手册则相当于计算机程序:每当房外人给出一个输入,房内的人便依照手册给出一个答复(输出)。

那么,房中人究竟能不能理解中文?